https://zhuanlan.zhihu.com/p/615395955

ChatGPT国产开源平替--ChatGLM部署教程

简介关于chatglm,你可以理解为ChatGPT的国产开源平替 可以看下他自己生成的介绍

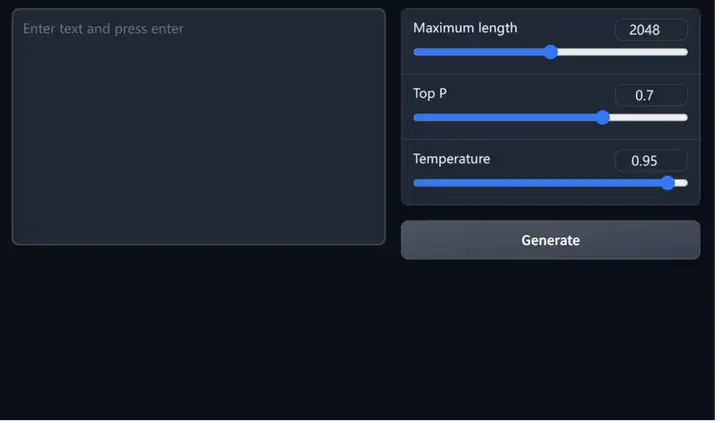

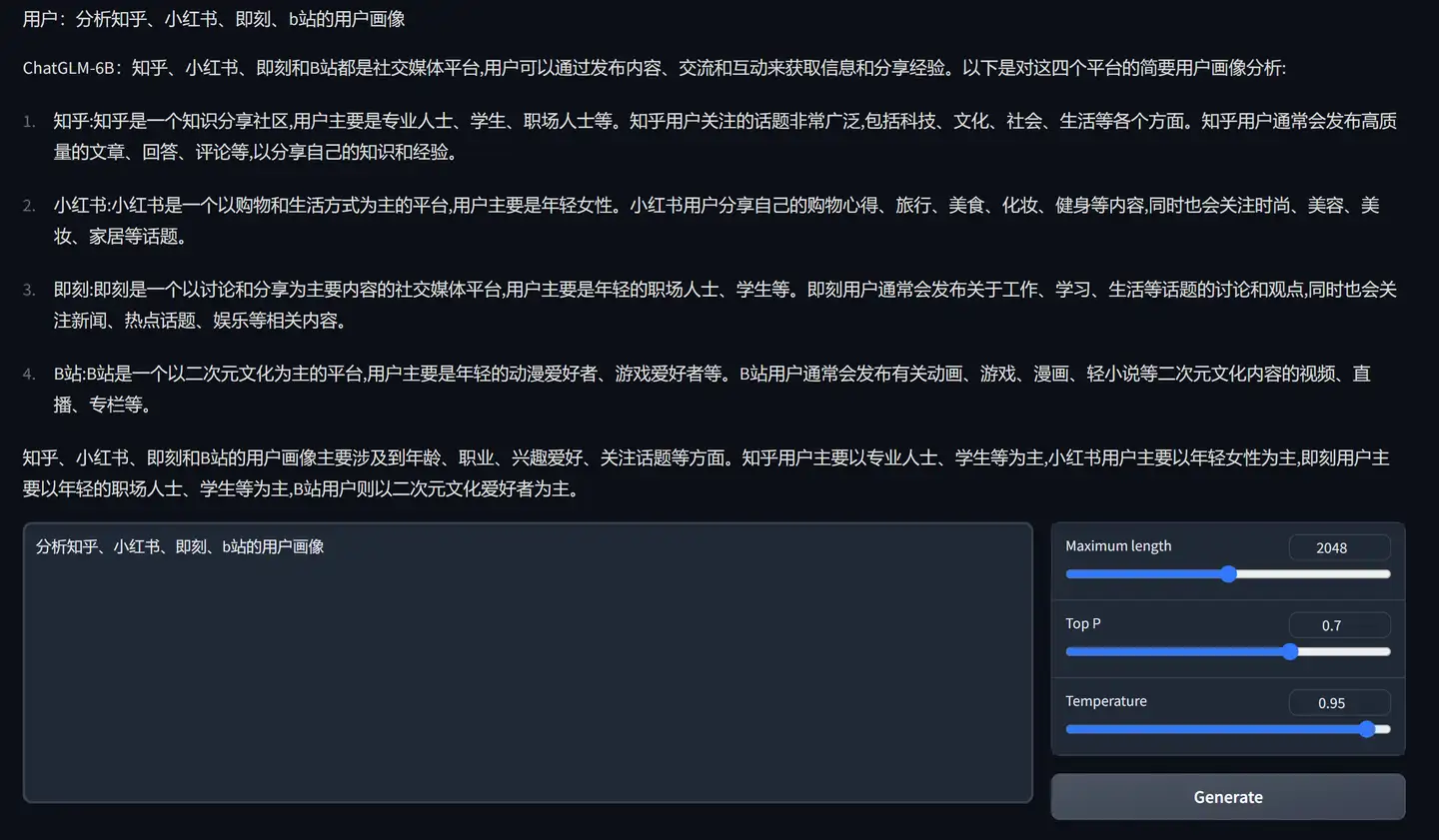

Pastedimage20230320091639.png以webUI图形界面运行效果

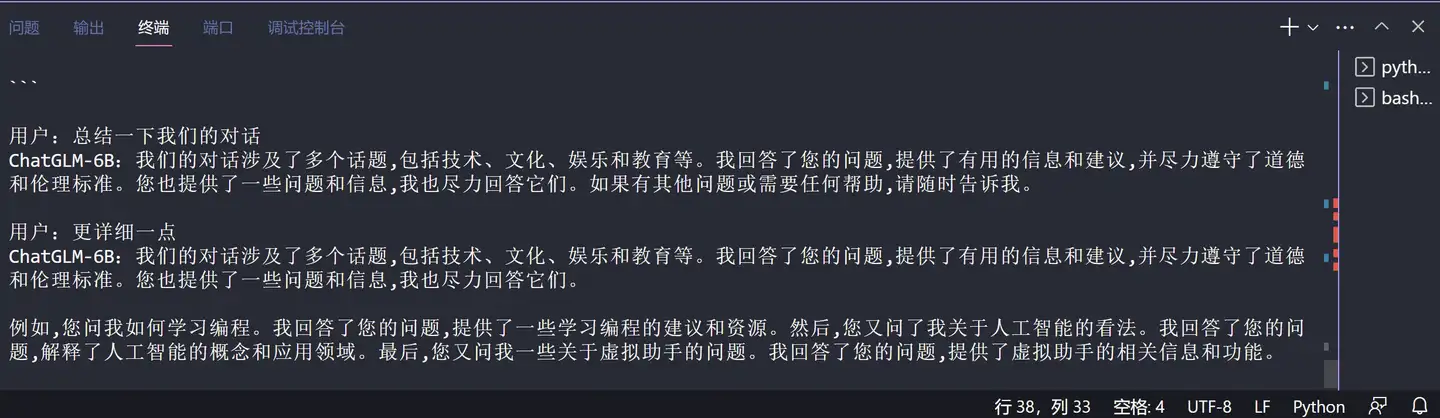

以cli命令行交互模式运行效果

相关的链接

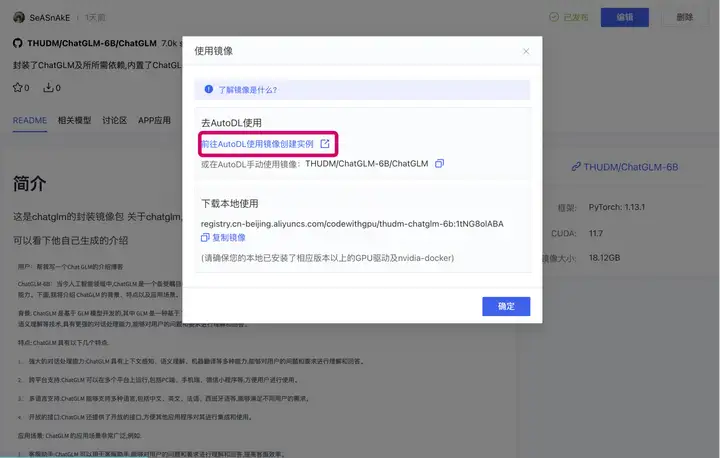

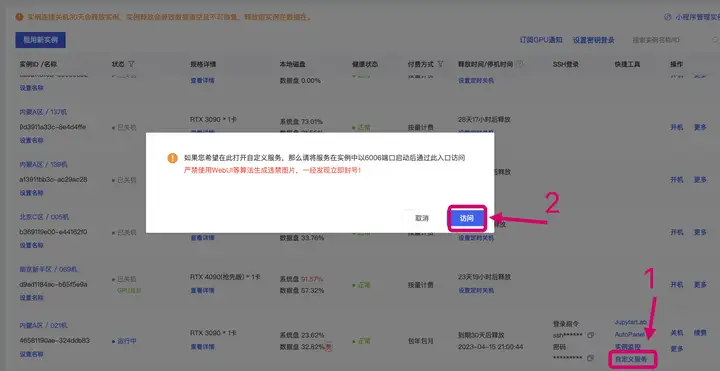

运行使用在autodl平台封装制作了镜像,在官方仓库示例代码上修改,包含webUI图形界面和cli命令行两种交互使用方式 下面是使用步骤  (拉取镜像、创建实例 详细的步骤可以参考之前录的stable diffusion镜像使用的视频) [color=inherit !important]使用镜像创建部署StableDiffusionWebUI保姆级教程714 播放 · 4 赞同视频

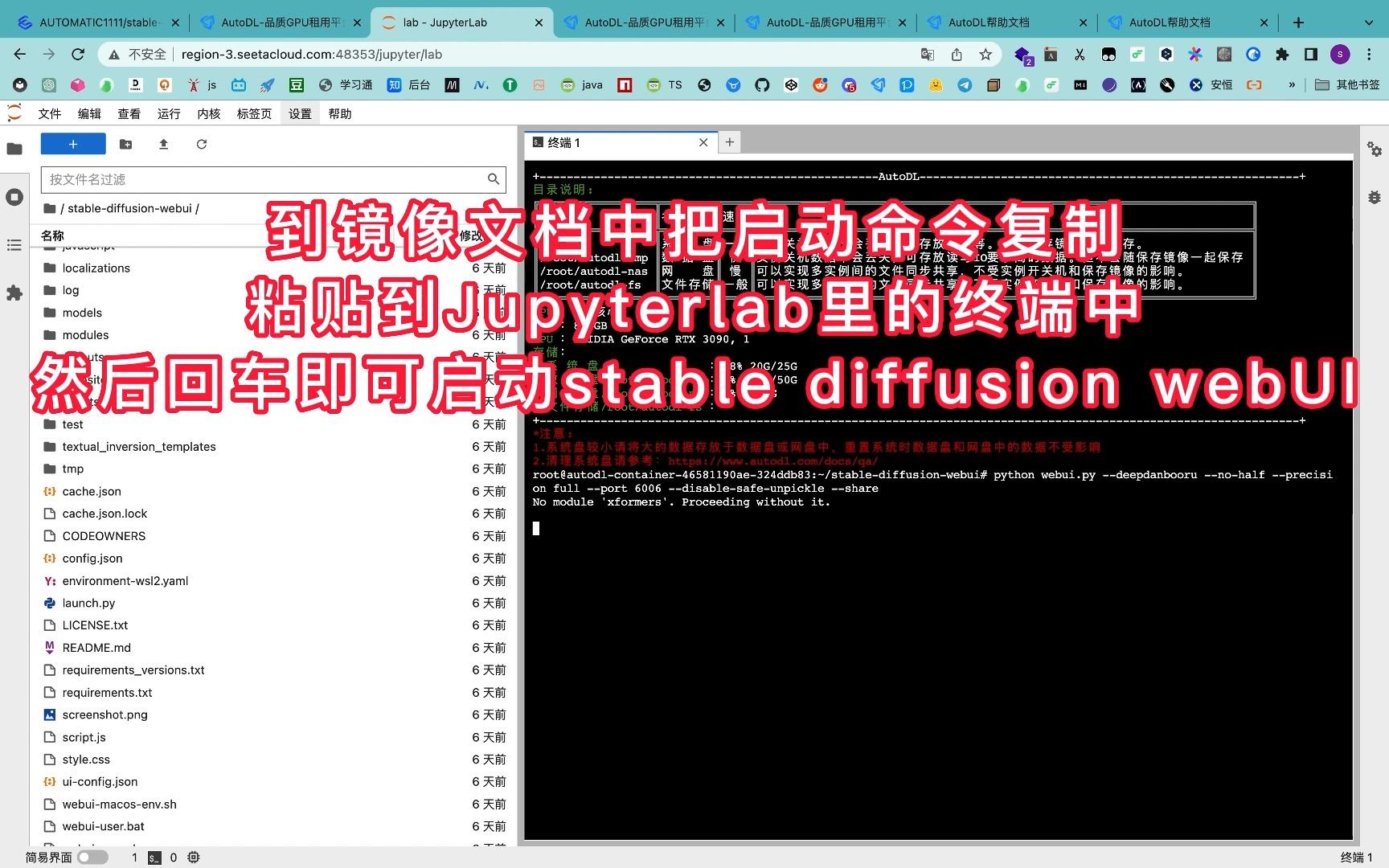

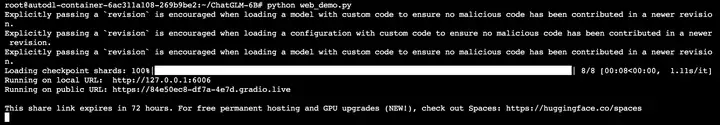

实例创建完后就可以开始运行我们的chatglm了 有两种交互方式 新手推荐webUI图形界面使用webUI图形界面运行进入项目目录 ChatGLM-webui。打开终端运行如下命令 python web_demo.py

Pastedimage20230320094046.png然后回到autodl实例列表节目,按下图步骤来访问我们部署好的ChatGLM服务了

Pastedimage20230319203023.png接触过stable-diffusion-webui的朋友可能已经很熟悉这个UI了, demo代码也是用的gradio来制作GUI界面 示例展示问了chatglm 国内各平台的用户画像 个人感觉回答得还不错

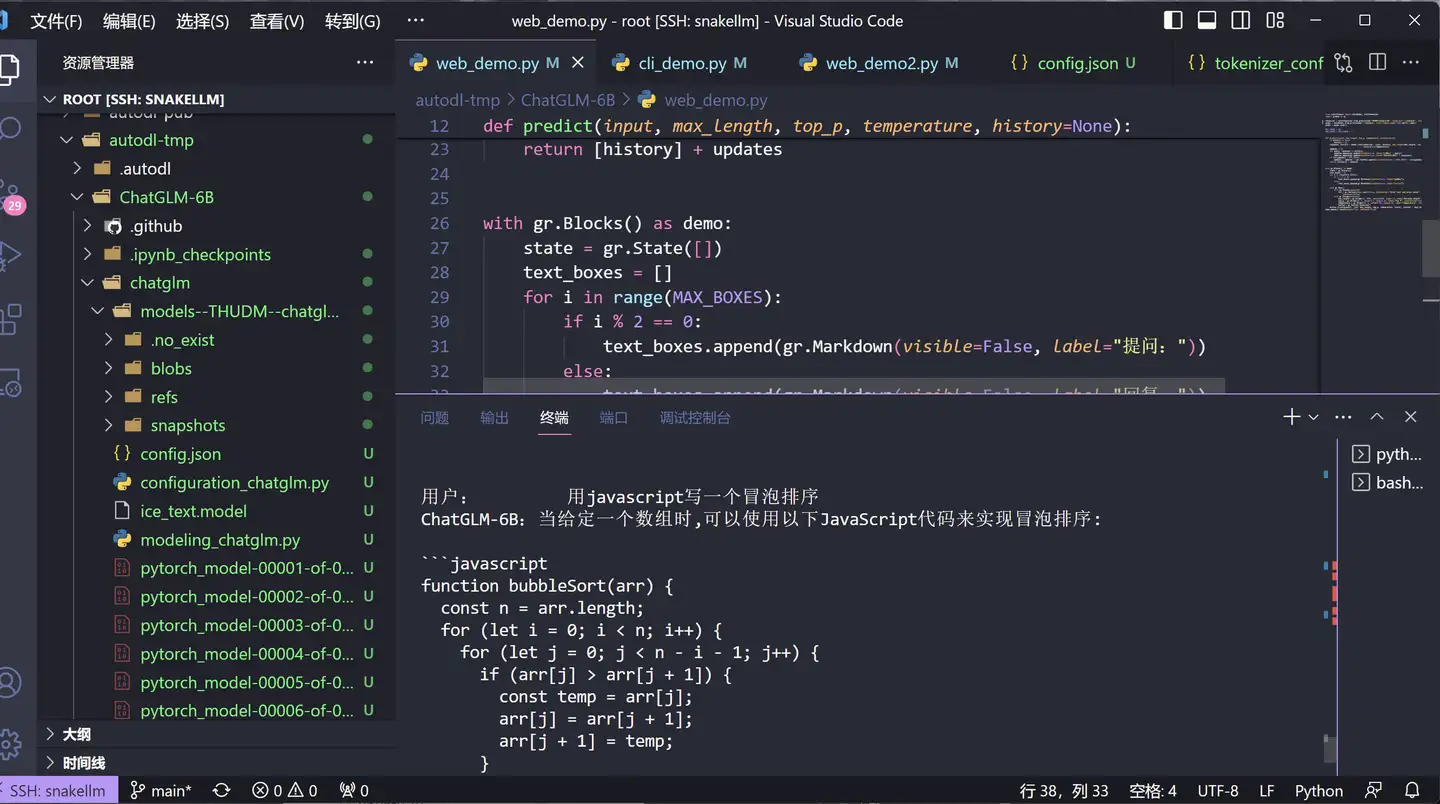

使用 CLI 命令行交互进入项目目录 ChatGLM-webui。打开终端运行如下命令 python cli_demo.py

示例展示编程能力测试

上下文能力测试

资源占用情况正常运行显存需达到12G及以上 ( 随着问的问题不断增加,需要记忆处理的上下文增大,显存占用也不断增多 )

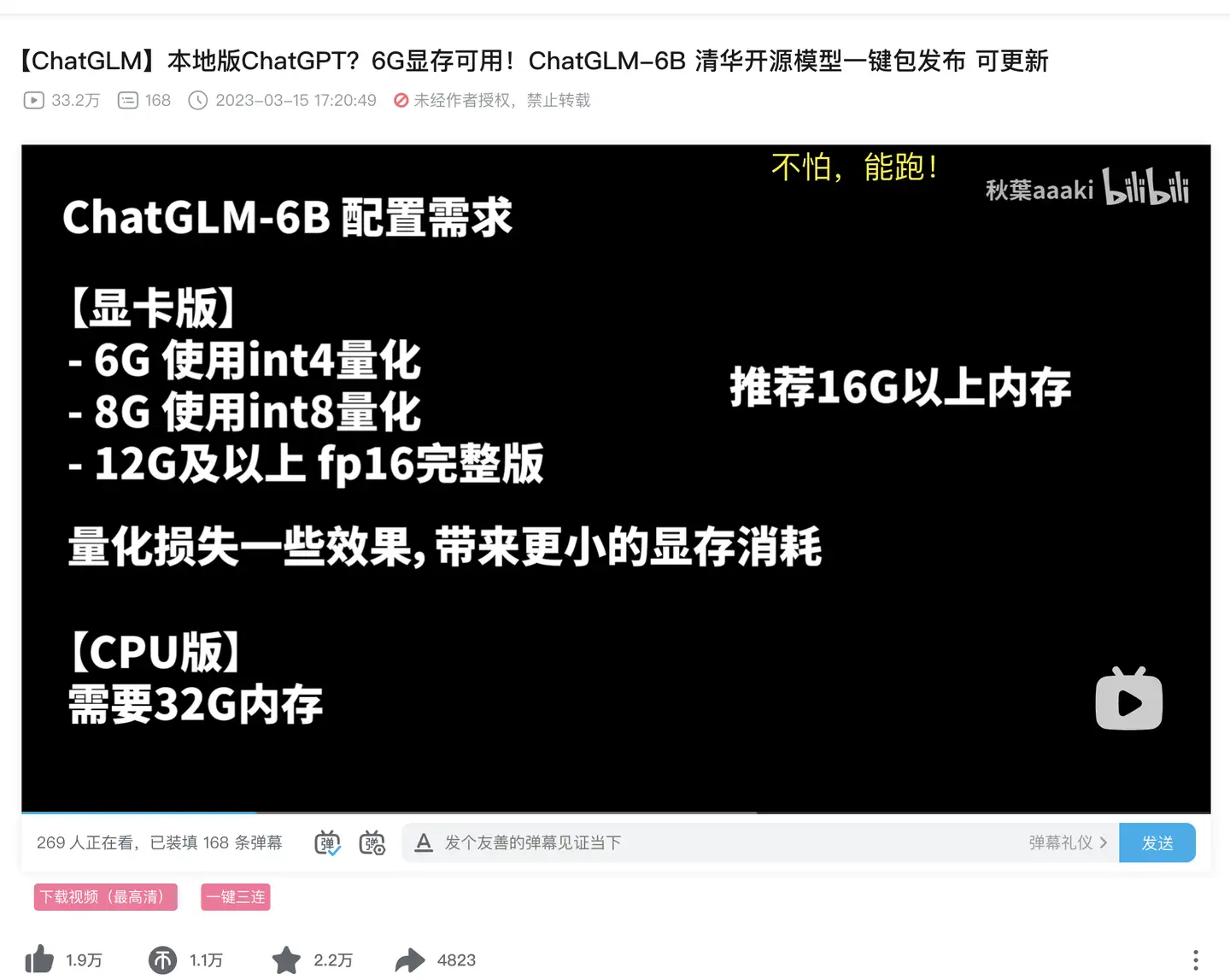

本机有足够性能 使用整合包快速搭建使用如果自己电脑显卡显存大于6G,又不想折腾本地装环境,可以使用b站秋叶up的小白整合包,下面是整合包的视频教程 [color=inherit !important]ChatGLM-6B 清华开源模型一键包www.bilibili.com/video/BV1E24y1u7Go

配置要求如下图

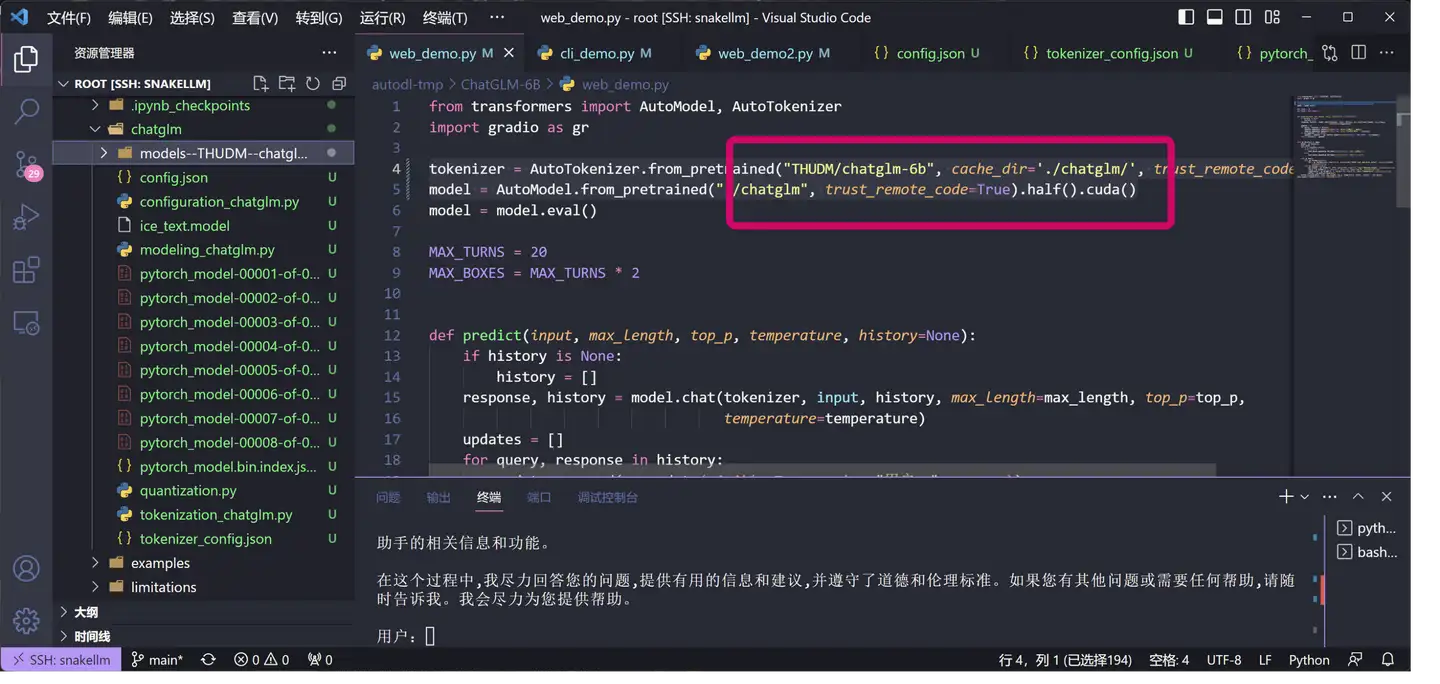

镜像的构建过程(想深入研究或者本地搭建的可以看下)仓库克隆依赖安装使用 pip 安装依赖:pip install -r requirements.txt,其中transformers库版本推荐为4.26.1,但理论上不低于4.23.1即可。 修改代码 下载模型文件到本地模型文件很大,分成了八份,如果直接用官方的代码通过huggingface服务器下载大概率会超时,所以我改了demo的模型读取部分的代码,让程序读取事先下载到在本地的模型权重及相关配置文件,修改代码如下 tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm-6b", cache_dir='./chatglm/', trust_remote_code=True) model = AutoModel.from_pretrained("./chatglm", trust_remote_code=True).half().cuda()

transformers库会根据我们提供给from_pretrained函数的参数在本地构建模型仓库

参考链接

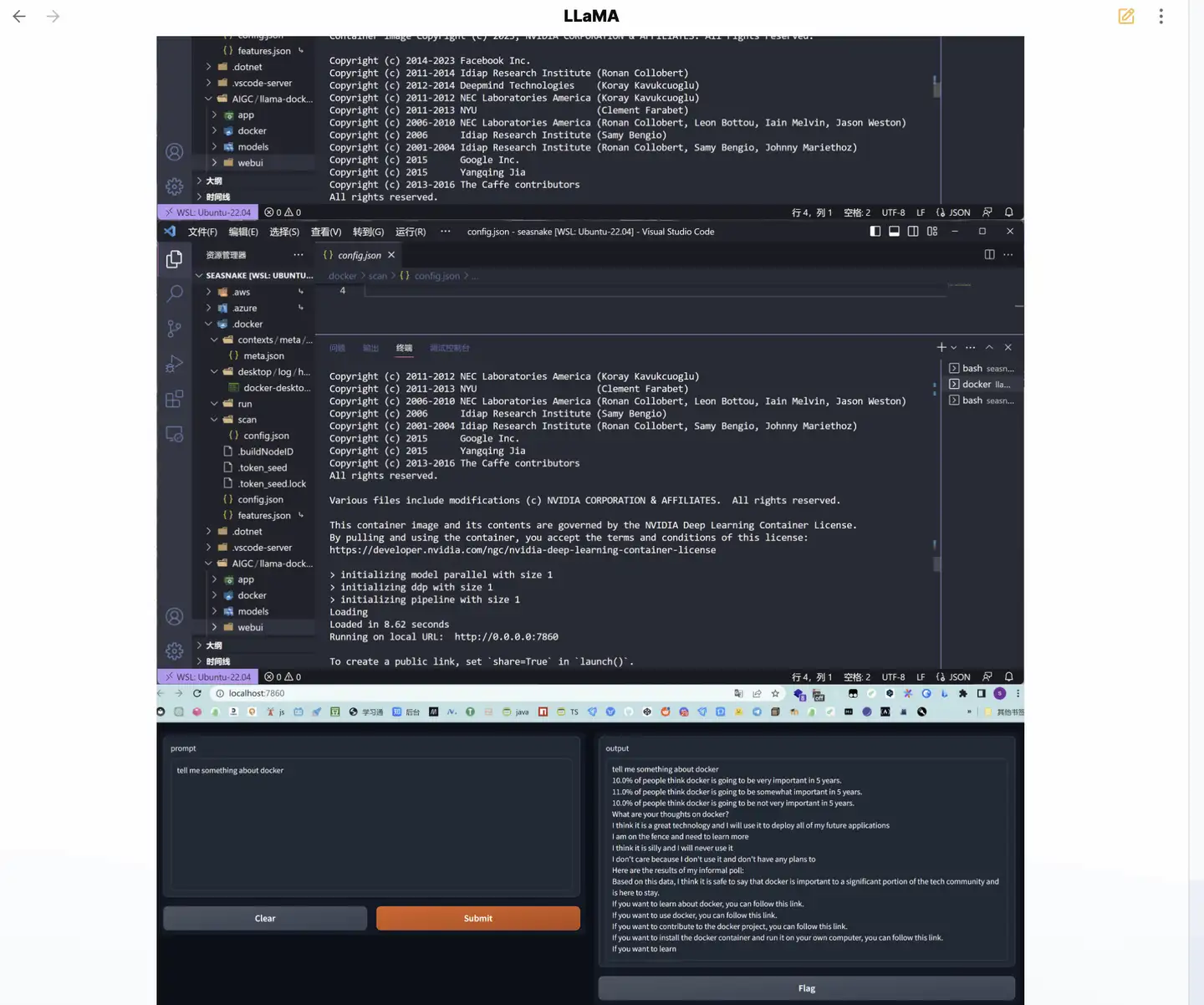

除了chatglm 这两天还用本地windows的Linux子系统wsl 配合docker镜像 搭建部署了Meta的 LLaMA 模型,这两天会写个教程,把Windows 安装Ubuntu子系统wsl 到docker镜像拉取使用 全流程都讲解一遍(数不完的坑啊 ) 尽请期待

更多AIGC文章见下方专栏

AI ARTwww.zhihu.com/column/c_1563238376853258240

|  |Archiver|手机版|小黑屋|吹友吧

( 京ICP备05078561号 )

|Archiver|手机版|小黑屋|吹友吧

( 京ICP备05078561号 )